ChatGPT的私有化部署

最近由于OpenAI对账号使用的监察收紧,只是以挂代理的方式,使用网页版GPT容易频繁掉线或是直接无权访问无法登录,能够使用的代理IP也十分局限,用着十分糟心。而以API的形式使用又涉及到付费问题,国内信用卡无法直接使用。所以在此基础上想着能否找到一个私有化部署Web版GPT的解决方案。

Pandora

简介

潘多拉 (Pandora),一个不只是命令行的 ChatGPT。

潘多拉实现了网页版 ChatGPT 的主要操作。后端优化,绕过 Cloudflare,速度喜人。

优点:

- 高峰期能绕过官方限制,继续使用。

- 应答速度直逼

PLUS,白嫖用户的福音。 - 官方故障的时候,它可能还是能跑。

- 多模式:网页/命令行/API,私有化部署。

- 不会像官方那样无故断线、报错。

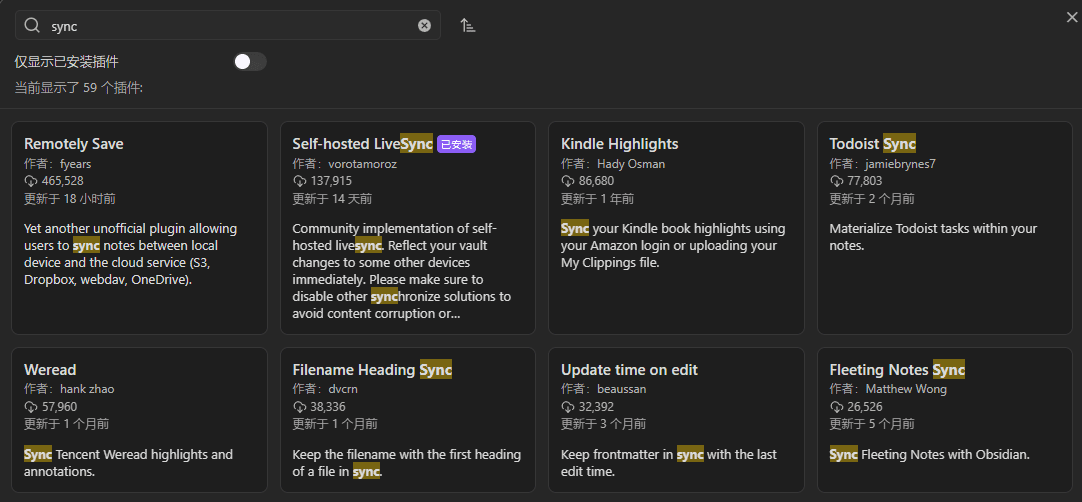

安装与运行

如果你恰好有一台国外的服务器,那么直接docker运行:

1 | docker pull pengzhile/pandora |

其中关于-e的环境变量参考官方说明进行使用配置

PANDORA_ACCESS_TOKEN指定Access Token字符串。PANDORA_TOKENS_FILE指定一个存放多Access Token的文件路径。PANDORA_PROXY指定代理,格式:protocol://user:pass@ip:port。PANDORA_SERVER以http服务方式启动,格式:ip:port。PANDORA_API使用gpt-3.5-turboAPI请求,你可能需要向OpenAI支付费用。PANDORA_SENTRY启用sentry框架来发送错误报告供作者查错,敏感信息不会被发送。PANDORA_VERBOSE显示调试信息,且出错时打印异常堆栈信息,供查错使用。

安装完成后,就可以用过你指定的http://ip:port来访问一个极简版的 ChatGPT 了。因为是国外的服务器,所以也无需代理了。

后记

个人在自己的服务器进行配置的时候遇到一个问题:安装运行完成后,无法直接通过ip:端口的形式进行访问,而通过Nginx以域名的形式进行反向代理后可以正常访问。推测是和容器http服务形式有关,暂未细察,先留个坑。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 InAction!

评论